CONSERVATOIRE

NATIONAL DES ARTS ET MÉTIERS

Centre Régional

Languedoc-Roussillon

Spécialité :

INFORMATIQUE

EXAMEN PROBATOIRE

Les techniques des moteurs de recherche

Soutenu le 10 Février 2003

par

Cédric

BOUTTES

JURY

Président : Jean-Yves RANCHIN

Membres

: Marc NANARD

Mathieu

LAFOURCADE

SOMMAIRE

INTRODUCTION………………………………………………………………………………1

I - LES DOCUMENTS DU

WEB ET SA STRUCTURE : IMPACT SUR LE TRAVAIL DES MOTEURS DE RECHERCHE……………………………………………………………………………………2

I-1.

Pages et documents ………………………………………………………………2

I-2

Eléments de structure des documents HTML ………………..……..……2

I-2-1 Les tags classiques…………………………………………………………… … 2

I-2-2 Les méta tags…………………………………………………………………… 3

I-3

Structure du Web et accessibilité des documents ………………….….4

I-3-1 Une structure

en nœud papillon…………………………………………………4

I-3-2 Le Web

invisible………………………………………………………………….5

II- ANNUAIRE ET MOTEURS DE

RECHERCHE : PRINCIPE GENERAL DE FONCTIONNEMENT………………………………………………....6

II-1. Les annuaires ……………………………………………………………………….6

II-2. Les moteurs de recherche ……………………………………………………..7

II-2-1

Définition………………………………………………………………………...7

II-2-2

Historique………………………………………………………………………..7

II-2-3 Le

fonctionnement d’un moteur de recherche………………………………...7

Ø

La collecte des données………………………………………………………7

Ø

L’indexation…………………………………………………………………..8

Ø

Recherche et présentation des pages………………………………………..8

II-3. Mesures de performances d’un moteur de

recherche……………...9

III- AUTRES OUTILS BASES SUR

L’UTILISATION DE MOTEURS DE RECHERCHE ……………………………………………………………………………10

III-1.

Les méta-moteurs………………………………………………………………..10

Ø Les

méta-moteurs en ligne…………………………………………………………10

Ø Les

méta-moteurs clients…………………………………………………………..11

III-2.

Les outils de recherche automatique……………………………………12

IV- LES TECHNIQUES D’INDEXATION………………………………………….13

IV-1. La technique d’indexation en texte intégral ………..………………….13

Ø Exclusion des mots vides de

sens………………………………………...………..13

Ø L’indexation des mots……………………………………………………………..14

Ø Calcul de la fréquence

d’apparition………………………………………………14

Ø Calcul de la localisation…………………………………………………………...14

Ø Création d’un index inversé………………………………………………………14

IV-2.

L’indexation par mots clés

………………………………………………….15

IV-3.

L’indexation par Thésaurus

…………………………...……………………16

IV-3.1 Description et

exemple………………………………………………………..16

ØDescripteurs,

ou termes préférentiels, ou termes autorisés………………16

ØTermes

non-descripteurs, ou synonymes, ou termes exclus……………...16

Ø

Structure du Thésaurus……………………………………………………16

ØConséquences au niveau

de l’indexation………………………………….17

ØConséquences au niveau

de la recherche………………………………….17

ØExemple du Thésaurus du

MeSH………………………………………….17

IV-3.2 Avantages et

inconvénients de la méthode d’indexation contrôlée par thésaurus par rapport à

la méthode d’indexation libre du texte intégral…………18

VI-4.

La méthode linguistique d’indexation…………………………………...19

IV-4.1 Introduction

et comparaison par rapport aux méthodes d’indexation

précédentes……………………………………………………………………………19

IV-4.2 Principes

des techniques linguistiques d’indexation……………………………………………..…………..….20

1) Le niveau morphologique……………………………………………...20

2) L’analyse syntaxique…………………………………………………..21

3) L’analyse

sémantique……………………………………………..…...22

IV-4.3

Deux niveaux d’utilisation des techniques linguistiques……………………24

ØApproche privilégiant l’analyse linguistique au

niveau de l’indexation…………………………………………………………………….24

ØApproche privilégiant l’analyse linguistique au

niveau de la recherche……………………………………………………………………….24

IV-4.4 Comparaison

de l’approche privilégiant l’analyse linguistique au niveau de l’indexation et

de l’approche privilégiant l’analyse linguistique au niveau de la

recherche……………………………………………………………………………....25

V- LES MODES DE

RECHERCHE …………………………………………….……26

V-1. Le mode requête en langage booléen……………………………….……26

Ø Les opérateurs booléens……………………………………………………26

Ø La syntaxe…………………………………………………………………...26

ØLes opérateurs de proximité……………………………………….…….…27

Ø L'utilisation des parenthèses………………………………………………27

Ø La recherche par zone……………………………………………………...27

ØLa troncature………………………………………………………………..28

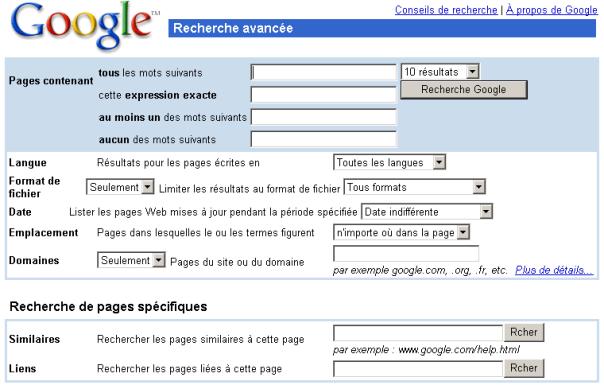

ØLe mode recherche avancé…………………………………………………28

ØRecherche floue……………………………………………………………..28

Ø La technique d’expansion de requête …………………………………….28

Ø La recherche par question…………………………………………………29

Ø La recherche par similarité de

document…………………………………29

ØLa recherche par le sens des mots………………………………………….29

Ø Un mode de recherche prenant en compte la connotation

du discours et autorisant une recherche sur des groupes nominaux……………………….30

Ø Le mode recherche en langage naturel……………………………………31

VI-1. Les méthodes de tri utilisées……………………………………………….32

VI-1.1 Le tri par pertinence…………………………………………………….33

VI-1.2 Tri par

popularité ………………………………………………………..34

ØLa méthode basée sur la co-citation ………………………………………34

ØLa méthode

basée sur la mesure d'audience ………………..…………….34

VI-2. Les outils

d’affinage des résultats……………….………………………..38

VI-2.1

L’utilisation des réseaux

sémantiques ……………..………………..38

Ø Exemple du réseau sémantique spécialisé du

projet UMLS……………………..38

Ø Exemple de réseau sémantique dans le cas du vocabulaire courant……………39

Ø

Live Topics………………………………………………………….………………39

CONCLUSION…………………………………………………………………………………….41

BIBLIOGRAPHIE

REMERCIEMENTS

Je remercie le tuteur de ce sujet, Mathieu LAFOURCADE pour

m’avoir guidé dans mes recherches et pour m’avoir reçu au LIRMM afin

d’effectuer ensemble les corrections nécessaires à la finalisation de ce

rapport.

Je tiens également à

remercier Olivier MASSIOT (Responsable

de la R&D de la société DATOPS), pour avoir été disponible pour répondre à

mes nombreuses questions.

RESUME

Le développement des réseaux locaux et de l’Internet

a totalement libéré l’accès à l’information. Chacun peut désormais consulter au

gré de ses besoins les documents stockés par centaines de giga-octets dans les

bases de données de l’entreprise ou sur les serveurs Web répartis dans le

monde.

Cependant la masse des données accessible est

désorganisée et en pleine expansion.

Les outils de recherche doivent continuellement

s’adapter à cet univers en pleine évolution.

Ceux-ci doivent satisfaire l’utilisateur aussi bien

en terme de pertinence que d’exhaustivité de l’information retournée.

Ce rapport présente les principales technologies

utilisées par les moteurs de recherche pour atteindre cet objectif.

Mots clés :

moteur de recherche, indexation, hyper-texte,

linguistique, sémantique, ontologie, requête, classement, pertinence

CONVENTIONS

TYPOGRAPHIQUES

[1] Introduit la référence [1]

dans la partie bibliographique de ce rapport

Remarque : L’annexe 1

de ce rapport est une liste des url des moteurs de recherche cités qui n’ont

pas de référence ou d’url directement précisée dans le texte de ce rapport.

La problématique actuelle, en terme de gain de connaissance, n’est plus comme par le passé d’accéder à l’information mais de s’y retrouver : « Trop d’informations tue l’information ». C’est le paradoxe qu’a fait naître le développement des Nouvelles Technologies de l’Information et de la Communication (NTIC).

Internet qui à l’origine était un outil d’échange de

connaissances réservé au domaine scientifique s’est développé progressivement

vers un espace informationnel ouvert. Tout le monde peut maintenant accéder à

l’information mais aussi en déposer. Le rythme de croissance étant estimé à un

million de pages supplémentaires par jour, le web totalise à l’heure actuelle

quelques milliards de pages.

Face à cela les données sont de plus en

plus hétérogènes aussi bien en terme de support que de connaissance, sans

compter les problèmes de multilinguisme. Et qu’en est il de la structure ?

Si tant est qu’on puisse la définir, celle-ci est en perpétuelle

mouvance : les url qui sont les seul moyens d’accès aux pages,

apparaissent et disparaissent. De plus un certain nombre de ces url est

difficilement accessible.

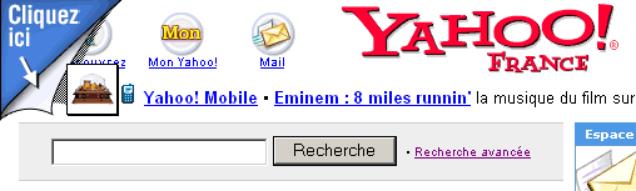

Un besoin de classification de cette masse

informationnelle a fait naître des outils comme les annuaires (e.g. Yahoo www.yahoo.fr ). Ceux-ci en s’inspirant d’une

logique documentaire essayent de ranger les sites dans des répertoires

thématiques. Dans ces systèmes le référencement des sites est manuel. Le nombre

de site est donc limité. Ceci réduit donc ce qui fait le charme d’Internet

c’est à dire l’exhaustivité.

Les moteurs de recherche proposent donc la solution

complémentaire. La recherche est basée sur le contenu des documents à partir de

requêtes formulées par l’utilisateur dans le but de rapatrier les url

dynamiquement.

La problématique de ces outils sera alors de trouver

un bon compromis entre l’exhaustivité et la précision en terme de réponse.

Ce rapport présente en première partie une vision de la structure du web et la nature des documents qu’il contient. Les moteurs de recherche pour être véritablement performant doivent s’adapter à ces paramètres. La deuxième partie est une courte description des annuaires et une présentation du principe général de fonctionnement des moteurs de recherche et de la mesure de leur performance. La troisième partie présente d’autres outils qui utilisent les moteurs de recherche, tel que les méta-moteurs et les agents de recherche automatique qui pour ces derniers sont utilisés dans la constitution de bases de connaissances sur un sujet. En quatrième partie l’aspect technique est abordé en expliquant et comparant les différentes méthodes d’indexation sur lesquelles peuvent se baser les moteurs. Il faut préciser que certaines de ces méthodes d’indexation ne sont véritablement efficaces qu’utilisées par des moteurs sur le contenu d’un site spécialisé. La cinquième partie est un éventail des différents mode de recherche que peuvent proposer les moteurs à l’utilisateur. Enfin en dernière partie les principales méthodes de tri et d’affinage des résultats issus des requêtes des utilisateurs sont décrites.

I -

LES DOCUMENTS DU WEB ET SA STRUCTURE : IMPACT SUR LE TRAVAIL DES MOTEURS

DE RECHERCHE

Sur le Web, une page ou un document correspondent à un fichier écrit principalement au format HTML (Hyper Text Markup Langage), langage de description de données multimédias affichées par les logiciels « navigateurs» (ou browsers en anglais), comme Netscape Navigator ou Microsoft Internet Explorer.

Le nom du fichier HTML est du type Document.html,

et son adresse (appellée URL pour Uniform Ressource Locator) ressemble à

ceci : http://www.serveur.fr/Repertoire/SousRepertoire/Document.html

A noter que dans le nom du serveur, le dernier terme

indique le pays (.fr pour France) ou le type d’entreprise ou d’organisme

délivrant l’information (par ex .org pour organisation

à but non lucratif, .com pour organismes à but commercial).

HTTP (Hyper Text Transfert Protocol) est le protocole

de communication, entre un navigateur (le client) et un serveur connecté sur

Internet, permettant le transfert des pages Web. Il existe d’autres protocoles

sur Internet, comme le protocole FTP qui permet de télécharger des fichiers à

distance. De même qu’il existe d’autres applications susceptibles de détenir de

l’information : forums de discussion (newsgroups) et liste de diffusion

(mailing-lists).

Dans un document HTML, on trouve tous les éléments nécessaires à l’affichage des informations : texte et formatage (gras, italique, taille relative des caractères les uns par rapport aux autres), nom et adresse des images et illustrations, texte des liens (mots en couleurs et soulignés) et adresses nommées hyperliens vers lesquelles l’utilisateur sera dirigé s’il clique dessus, etc.

Les moteurs et les annuaires sur le net qui effectuent

leur recherche sur le Web à partir des documents HTML travaillent pour élargir

les fonctionnalités de recherche à d'autres formats de fichiers que le HTML.

En tant que

pionnier, Google a depuis 1998

ajouté à son moteur la possibilité d'indexer plusieurs fichiers différents de

l'html, tels que les images (gif ou jpg), les documents PDF, TXT, PostScript,

les applications de la suite Microsoft Office et d'autres formats avec lesquels

nous tous travaillons régulièrement. Il est vrai que plusieurs autres outils de

recherche incluent aujourd'hui des formats de fichiers différents de l'HTML,

mais Google reste celui qui pour premier les a introduits et a constamment

agrandit la gamme des extensions supportées, arrivant ainsi en début 2002 à

compter environ 2 milliards de documents indexés. Par exemple pour faire

uniquement une recherche sur les documents

pdf il suffit d’ajouter filetype:pdf aux critères de recherche.

I - 2 Eléments de structure des documents HTML (document 1)

I-2-1 Les tags classiques

Le document :

Un document HTML est inclus entre les deux balises

<html> et </html>.

L’en-tête :

Un document bien formé doit comporter un en-tête et un

corps. L’en-tête est placé entre les balises : <head></head>.

L’en-tête peut contenir divers éléments comme le titre de la page ou diverses

indications concernant son contenu qui peuvent être contenu dans des méta-tags.

Le titre :

Le titre est placé entre les balises <title> et </title>. Celui-ci est souvent utilisé par les robots des sites de recherche pour déterminer le classement des sites indexés. Ainsi, un site contenant un mot donné dans le titre sera mieux classé par rapport à ce mot que si ce dernier figurait simplement dans le corps du document.

Le corps :

Le corps du document est inclus entre les tags

<body> et </body>.

I-2-2 Les méta tags

Les balises META sont des balises HTML permettant d’indiquer

aux moteurs de recherche un certain nombre d’informations sur le contenu d’une

page Web. Le terme META signifie METADATA, soit « l’information sur

l’information ». Seules 10 à 20 % des pages Web contiendraient ces

indications.

Voici

quelques exemples de balises META (voir aussi document 1 page

précédente) :

- <Meta name= " Author

" content = "nom de l'auteur ou des auteurs de la page">

- <Meta name= " keywords " content = "liste de mots clés

séparés par une virgule">

- <Meta name= " description " content = "résumé du contenu

de la page, texte pris en compte par la majorité des moteurs de recherche qui

affichent ce texte (les 100 premiers mots) lors de recherches sur les moteurs">

- <Meta name= " Robots " content = "indique au robot s'il

doit indexer la page (index ou noindex) et s'il doit indexer ou non les pages

liées (follow, nofollow)"> : ceci permet de cacher aux utilisateurs

non concernés tout ou partie d'un site.

Remarque : Certains concepteurs de sites utilisent les mots clés

de manière abusive en les multipliants dans l’espoir d’être mieux référencés

par les moteurs ; cependant certains moteurs de recherche les refusent

d'office au-delà d'un certain nombre (si on cite plus de huit fois le même mot

clé, le moteur considère que l’on tente de "polluer" (spammer) ses

index et la page est déclassée à la pondération des réponses).

Limites

des balises META : Tous les

moteurs de recherche ne les prennent pas en compte (Excite ou WebCrawler, par

exemple). Lycos et NorthernLight indexent le texte des balises mais n'affichent

pas la zone description dans leurs résultats. Infoseek, HotBot et AltaVista

indexent par contre, pour leur part, tous les mots clés de la balise Keywords

et affichent le contenu de la balise Description dans leurs résultats. Dans le

cas d'AltaVista, l'utilisation de ces balises est limitée à 1024 caractères.

I-3 Structure du Web et accessibilité des documents

I-3-1 Une structure en nœud papillon

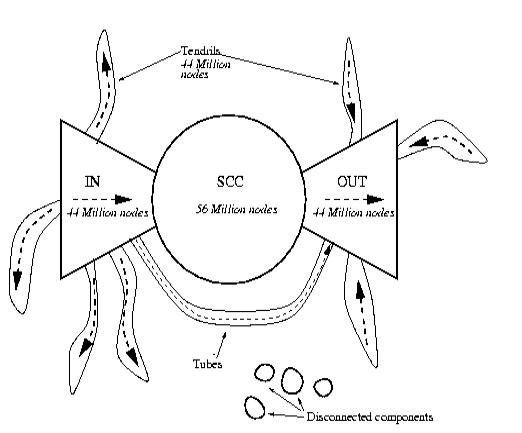

Pendant de longues années, l’idée couramment admise était que le Web visible (indexable par les moteurs de recherche), à l’image d’une toile d’araignée, était composé de pages bien connectées entre elles. En partant d’un certain nombre d’URLs bien choisies, les robots des moteurs de recherche devaient donc être capables de sillonner le cyberespace et de rapatrier la quasi-totalité des pages dans leur index, à l’exception, bien sûr, des pages crées juste après leur passage.

Cependant une étude menée par Altavista, Compaq

et IBM a conduit à une représentation graphique dite en "noeud papillon"

du Web mondial [2]. Elle montre

l'existence de différentes régions rendant la navigation sur le Web difficile,

voire impraticable. Les recherches précédentes, basées sur de simples

échantillonnages du Web, conduisaient à un haut degré de connectivité entre les

sites. Au contraire l'analyse de plus de 200 millions de pages Web prouve que

le Web est divisé en quatre grandes zones. On a pu constater aussi qu'un nombre

impressionnant de sites était inaccessible par l'absence de liens hypertextes.

Or, ces liens sont ce qu'un internaute utilise le plus au cours de ses

navigations sur le réseau.

La théorie du "noeud papillon" permet

d'appréhender l'organisation complexe du web (document 2) :

-

La partie centrale

(SCC-strongly connected component – sur le document 2) est constituée du

« noyau ultra-connecté » et contient moins d’un tiers des pages Web

(28 %). La navigation y est aisée, car chacune des pages est reliée aux autres

par des chemins de liens hypertexte. Ce noyau compact constitue le coeur du

réseau Internet. C’est lui qui permet de passer, par clics successifs, de

n’importe quelle page du IN vers une page du OUT. Ce sont les pages du coeur

que les robots des moteurs de recherche indexent en priorité et c’est à partir

de leurs liens qu’ils explorent le Web.

-

La partie gauche (IN)

contient les pages d’origine et représente environ un cinquième du réseau

(21%). Ces pages offrent des liens vers le coeur du Web, mais l’inverse n’est

pas vrai ; on trouve dans cette catégorie, par exemple, les pages de

moindre intérêt pour la communauté des netsurfers (certaines pages personnelles

…) ou les pages de création récente, qui n’ont pas été reconnues par leurs

pairs et vers lesquelles ne pointent encore que peu de liens.

-

La partie droite (OUT)

correspond aux pages de destination ; elles représente également un

cinquième du réseau. Ces pages sont accessibles depuis le coeur du Web, mais

aucun retour n’est possible. On trouve dans cette catégorie, notamment, les

sites commerciaux (site d’entreprises, de commerce électronique…), vers

lesquels pointent de nombreux liens, mais qui, eux, n’en proposent pas, ou seulement

en interne.

-

Une dernière zone,

représentant également un cinquième du Web (Tendrils), est composée de pages

non connectées au coeur du réseau. Ces pages sont accessibles depuis les pages

d’origine et/ou donnent accès aux pages de destination.

-

Enfin, près de 10 % des

pages Web sont totalement déconnectés des autres pages.

Ces résultats devraient permettrent une meilleure

connaissance de la topographie du Web et donc améliorer le travail des robots

des moteurs de recherche.

I-3-2 Le Web

invisible

Parallèlement au Web visible, composé de sites en

accès libre offrant des pages reliées entre elles, il existe un Web invisible

dont le volume est bien plus important et qui comprend :

- Les sites Web

construits autour d’une base de données, interrogeable via un formulaire

de recherche et qui donc génèrent les pages dynamiquement ou bien

interrogeable via un formulaire de recherche interne.

- Les divers sites où

il est nécessaire de s’identifier préalablement.

- Les sites offrant

des fichiers dans certains formats non reconnus par les robots

- Les pages Web qui

contiennent la balise [no robot]

La société BrightPlanet <www.brightplanet.com> préfère les

appellations de Deep Web, qu’elle oppose à « Surface Web » (document 3). Pour elle en effet, le Deep Web n’est

pas invisible; il est certes ignoré par les moteurs de recherche classique,

mais les nouveaux outils de recherche offline (et en particulier LexiBot <http://www.lexibot.com/>,

qu’elle développe), interrogent ses ressources. Lexibot

est en fait un métamoteur qui interroge des moteurs de recherche mais également

des ressources du Web invisible comme des bases de données, pouvant lancer des

douzaines de requêtes simultanées.

Pour sensibiliser les internautes aux richesses de ce

gisement d’informations, la société BrightPlanet a tenté de comparer le type de

sites et le nombre de documents disponibles sur le Web visible et le Web

invisible. Elle a pour cela analysé le contenu des sites recensés par sa base

CompletePlanet.com (www.completeplanet.com),

qui décrit plus de 38500 ressources du Web invisible. Elle a ensuite comparé

ces résultats avec ceux obtenus par le NEC Research Institute sur le Web

visible.

Les résultats de ces comparaisons sont parus fin juillet 2000, dans une étude intitulée The Deep Web : Surfacing Hidden Value [3] ; et ils sont surprenants. D’après les auteurs, le Deep Web contient plus de 550 milliards de documents ; il est donc 250 fois plus vaste que le Surface Web, si l’on compare les chiffres de BrightPlanet.com avec ceux de Cyveillance, publiés également en juillet 2000. Le nombre total de sites du Web invisible dépasse les 200 000, sachant que plusieurs bases accessibles depuis la même URL, comme les diverses bases de Dialog <www.dialogweb.com>ou de Lexis-Nexis <http://www.litec.fr/> par exemple, sont comptées pour un site ; d’autre part, et c’est une surprise, 95 % de l’information du Deep Web est accessible librement. Les bases du Deep Web enfin selon les auteurs fournissent plus d’informations de qualité que les sites du Surface Web.

Il ressort finalement de ces diverses études que :

-

les moteurs n’ont qu’une

indexation partielle du Web visible ;

-

le volume du Web visible

est très inférieur à celui du Web invisible ;

-

les sites les plus

riches appartiennent au Web invisible

Heureusement, il existe des outils spécialisés qui

identifient et interrogent les sites du Deep Web comme Lexibot précédemment

cité.

II- ANNUAIRE ET MOTEURS DE RECHERCHE : PRINCIPE GENERAL

DE FONCTIONNEMENT

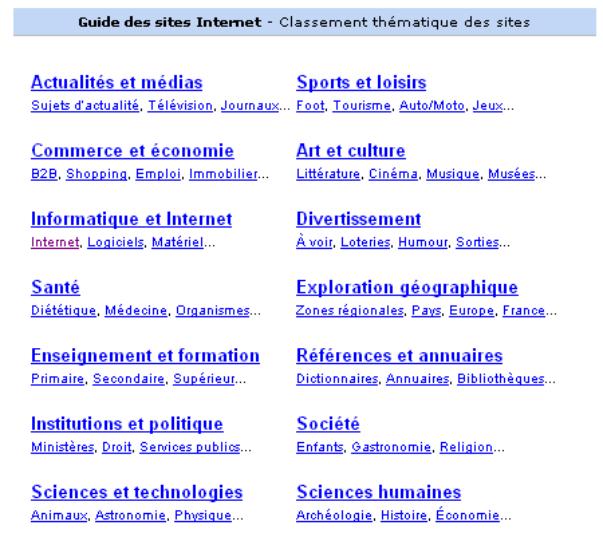

Il est important de rappeller les différences fondamentales qui existent entre les annuaires (également appelés répertoires ou index) et les moteurs de recherche ou robots. Ces deux familles d’outils représentent les bases de la recherche sur le Net, même s’il est vrai que chacune tend à évoluer vers le portail.

Si l’on compare le Web à une immense bibliothèque

rassemblant des millions d’ouvrages (chaque ouvrage étant un site Web), les

annuaires de type Yahoo <www.yahoo.com>

(document 4)ou Nomade <www.nomade.fr> peuvent être comparés au

catalogue de cette bibliothèque, fonctionnant sur le principe des banques de

données bibliographiques.

Les ouvrages/sites sont indexés avec leur titre et un très bref descriptif dans des rubriques et sous-rubriques. C’est une équipe de « cyberdocumentalistes » qui est chargée de tester les centaines de sites proposés chaque jour aux annuaires par les éditeurs, de vérifier les informations données en les complétant éventuellement et de classer les sites dans les catégories appropriées. Comme dans une base bibliographique, il y a un travail humain d’indexation derrière chaque référence.

Les annuaires proposent dès leur écran d’accueil une

liste de rubriques et de sous-rubriques et il suffit au visiteur de cliquer sur

un thème, puis sur des sous-thèmes successifs, pour afficher une liste de sites

répondant à sa question. Un choix nettement plus simple, pour le néophyte en particulier,

que celui des mots-clés qu’il faut indiquer à un moteur de recherche, mots-clés

qui doivent être précis si l’on veut pas être noyé sous une avalanche de

résultats. A cette simplicité d’utilisation, s’ajoute une autre qualité :

la liste des sites sélectionnés en bout de course est en général pertinente.

Ceci n’est pas surprenant, puisque l’indexation des sites est réalisée

manuellement par l’équipe éditoriale de l’annuaire.

En complément des diverses catégories, les écrans d’accueil des annuaires disposent le plus souvent d’une zone de saisie permettant d’effectuer une recherche par mots. La requête est alors lancée sur l’intégralité du catalogue, c’est-à-dire sur les catégories, les titres et les brèves descriptions des sites. Lorsque l’on lance une recherche par mots dans un annuaire, c’est un peu comme si on lançait une requête par mots sur les titres et les résumés des ouvrages d’une bibliothèque.

Quelques défauts : ils leur sont reprochés un manque d’exhaustivité de

par leurs mécanismes d’enrichissement (augmentation de la base répertoriée par

inscription des auteurs), ainsi que des insuffisances en cas de recherche

thématique très précise (nom de produit, de personne …).

Précurseurs dans le domaine de la recherche et de l’indexation de l’information sur le Web, les répertoires fournissent une réponse précise rapide et complète lorsque le besoin est lui-même simple et bien défini. Mais enfin de permettre des recherches plus globales, ils ont été rapidement complétés par des « moteurs de recherches ».

II-2. Les moteurs de recherche

II-2-1 Définition

On parle de moteur de recherche ou de robot

pour un dispositif technique qui fait des recherches sur un ensemble de

données. Dans le cas d’Internet, c’est un automate qui va utiliser le contenu

des pages HTML comme données sur lesquelles il va faire ses recherches. A

partir de ces éléments, le robot va stocker des données qui pourront être

réutilisées au moment de l’interrogation. L’interrogation d’un moteur de

recherche n’est plus dès lors qu’un accès à une base de données préalablement

remplie et organisée, interfacé par une page Web. Le robot, lui, est lancé de

façon invisible aux utilisateurs à des dates périodiques pour maintenir ses

tables à jour.

Cependant l’utilisation de ces outils ne se limite pas

à l’Internet et beaucoup sont utilisés pour faire de la recherche

d’informations limitée au contenu d’un site Intranet. C’est typiquement le

genre de logiciel qui est utilisé lorsqu’un site web offre des fonctionnalités

du type « rechercher sur ce site : ». Altavista par exemple

propose à la fois une version en ligne < http://fr.altavista.com/>

pour faire une recherche sur la totalité du Web mais aussi une version Intranet

payante nommée AltaVista Search Engine 3.0 [1].

D’autres entreprises commercialisent des moteurs adaptés uniquement à la

recherche sur site Intranet. C’est le cas par exemple de Sinequa avec le

logiciel Intuition [13].

On peut cependant se procurer certains moteurs de

recherche et d’indexation gratuitement. Un des plus populaire est le moteur

htdig (open source) également utilisé pour faire de la recherche sur un site

web donné. L’annexe

2 référence et

décrit un certain nombre de ces outils gratuits dont htdig.

II-2-2 Historique

WebCrawler a été un des premiers moteurs de recherche à être lancé sur le marché. Développé dans un projet de recherche de l’Université de Washington au début de l’année 1994, il a été une véritable réussite commerciale (car correspondant à un réel besoin des utilisateurs et aux ressources publicitaires générées). Au commencement de son exploitation, sa base de données contenait des informations sur 6000 serveurs Web. Son succès en a fait un outil très vite utilisé et dès la fin 1994, le service recevait plus de 15000 requêtes par jour. Depuis de nombreux moteurs ont été mis en circulation : Lycos, Altavista, Lockace, Hotbot, etc. Très nombreux aujourd’hui, seuls certains sont souvent utilisés.

II-3 Le fonctionnement d’un moteur de recherche

Pour une

majorité des moteurs, le principe de fonctionnement est généralement le même.

Le moteur collecte les données, les archive, les indexe, et les restitue par

ordre de pertinence. Il est composé de plusieurs éléments : un robot qui va

collecter les données, un moteur d'indexation, et un moteur d'interrogation (document 5).

Ø La collecte des données

Les moteurs

utilisent un robot souvent appelé spider ou crawler qui balaie

sans relâche le web et éventuellement les newsgroups pour en archiver

intégralement le contenu dans une base de

données.

En principe

le robot suit tous les liens qu'il rencontre, mais cet agent peut utiliser

différent types d'algorithmes pour allez chercher le maximum de pages et c'est

ce qui explique les différences de réponses de deux moteurs pour une même

requête. Actuellement la vitesse moyenne des robots est de 400 pages par

secondes sachant qu’un crawler travaille en parallèle avec d’autres crawler.

A chaque

fois que le crawler rencontre un lien, il compare cette adresse aux adresses

connues, il a alors 3 possibilités :

-

l’adresse est inconnue

-

l’adresse est connue

mais la date de la dernière visite sur la page est ancienne

-

l’adresse est connue

mais le date de la dernière visite sur la page est récente

Dans les

deux premiers cas, le crawler ajoute l’adresse de la page comme page à

archiver.

Le problème de ce type d'algorithme est la croissance importante de nombreux sites "isolés", c'est à dire sur lesquels ne pointent aucun lien venant d'autres pages ou sites web, et ceci entraîne un nombre important de sites non répertoriés par les moteurs. L'immensité de la tâche à accomplir explique qu'un certain délai soit nécessaire au renouvellement de la base de données ainsi crée et ceci explique que l'on puisse donc trouver sur des moteurs des pages qui n'existent plus. A l'inverse, plusieurs semaines voire plusieurs mois peuvent être nécessaires avant qu'une nouvelle page soit archivée. Un moyen d'accélérer les choses est alors d'indiquer manuellement (soumission) au robot l'adresse de la page "à visiter".

Sur le document 6 est

présenté un tableau comparant la quantité approximative de pages réellement

indexées par différents moteur de recherche avec la fréquence de mise à jour de

ces index (en date d’octobre 2002) [10].

Ø L’indexation

Le robot renvoie les informations collectées au moteur d’indexation pour qu’elles soient analysées. Ce dernier construit alors un index des mots rencontrés et stocke l’ensemble dans une base de données. On parle généralement d’indexation automatique. Cette liste de termes répertoriés est relié aux adresses des pages correspondantes sur le web. Grâce à un pointeur, ces pages peuvent être retrouvées facilement.

Ø Recherche et présentation des pages

Lors d'une

requête, le moteur d'interrogation analyse la question posée par l'internaute,

la traduit en un ensemble de mots, va rechercher les documents correspondants

et les propose par ordre de pertinence décroissant. C'est bien sûr la méthode

de calcul de la pertinence utilisée par le moteur qui est à prendre en compte

pour optimiser le référencement. Les critères de pertinence les plus souvent

rencontrés sont :

- La présence des mots clés dans

le titre, dans l'en-tête, dans le contenu de la page et éventuellement

dans les méta-tags

- La position (haut de page) des

mots clés dans la page

- La répétition (jusqu'à un

certain point) des mots clés.

C'est le

principe de localisation et de fréquence.

Cependant

il existe d'autres méthodes reposant sur des principes tout à fait différents

et indépendants du contenu des documents. Citons par exemple le tri par

popularité utilisé par Google.

Ainsi les

méthodes employées pour déterminer la pertinence d'un mot clé sont différentes

d'un moteur à l'autre, et c'est ce qui explique qu'une même page puisse avoir

une qualité de référencement très variable d'un moteur à l'autre sur le même

mot clé.

III- AUTRES OUTILS

BASES SUR L’UTILISATION DE MOTEURS DE RECHERCHE

III-1. Les méta-moteurs

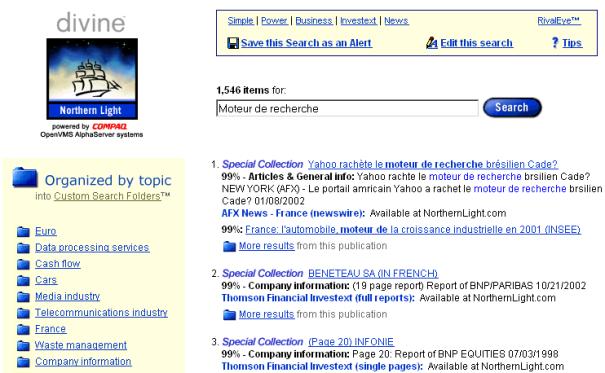

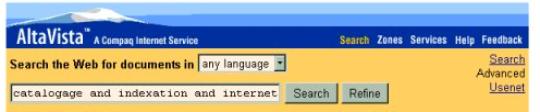

Les méta-moteurs sont des outils qui, pour

une même requête interrogent plusieurs moteurs de façon simultanée, rapatrient

les résultats, les synthétisent et proposent un récapitulatif des réponses

données. Le fonctionnement des méta-moteurs est décrit sur le document 8.

Les méta-moteurs se distinguent entre eux par :

·

le nombre et la nature

des moteurs interrogées ;

·

le traitement des

résultats : celui-ci es très variable, allant du listing brut au classement par

outils de recherche, jusqu’à la fusion avec élimination des doublons pour

certains.

Inconvénients des méta-moteurs : Il n’est pas permis, sur ces services, d’utiliser les

fonctionnalités avancées des moteurs de recherche (notamment les fonctions de

type host: , url: , title: d’Altavista, par exemple), tout simplement parce qu’elles varient

grandement selon les outils interrogés. D’autre part les méta-moteurs font la

synthèse de résultats fournis par plusieurs moteurs différents, classant chacun

leurs résultats de façons différentes, sans utiliser les mêmes critères de pertinence.

Ensuite les méta-moteurs ne récupèrent qu'un nombre limité de résultats de

chaque outil interrogé : entre 10 et 50 au maximum. De plus ils n'attendent les

résultats que pendant un temps limité aussi (le time out) qui est cependant

paramétrable.

Leur utilisation est efficace dans le cadre de

recherche sur des sujets très pointus où l’information est plutôt rarissime. Si

l’on utilise ces outils à l’aide de termes plutôt généraux on risque de générer

beaucoup d’informations non pertinentes. Pour palier à cela certains de ces

outils comme Copernic <http://www.copernic.com/> permettent

d’effectuer une deuxième recherche plus précise sur uniquement le résultat des

documents rapatriés avec la première requête. On approche ainsi l’information

pertinente par affinage successif.

Il existe deux grands types de méta-moteurs selon

qu'on les interroge à distance ou qu'on installe un logiciel sur son poste de

travail.

Ø Les méta-moteurs en ligne

Un serveur sert d'intermédiaire entre l'utilisateur et

les outils interrogés. Un formulaire en général limité permet d'exprimer sa

requête. Ce type de méta-moteur est surtout intéressant pour sa rapidité à

explorer de nombreux outils de recherche, mais les fonctionnalités en sont en

général très limitées.

·

DOGPILE < http://www.dogpile.com/>

DogPile, lancé en 1997,

supporte jusqu'à vingt-cinq outils de recherche. Il offre le choix entre une

recherche de pages web, de messages des News (Usenet), de fichiers, de dépêches

d'agences de presse, d'images et de fichiers mp3.Le résultat est classé

uniquement par outil de recherche, sans traitement de doublons.

·

IXQUICK <http://www.ixquick.com/>

Ixquick affirme s'adresser à

chaque outil de recherche dans leur syntaxe propre, ce qui lève un des

principaux reproches fait aux méta-moteurs.

·

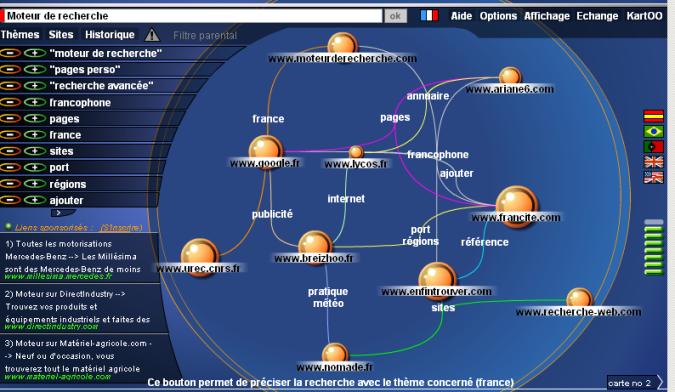

KARTOO <http://www.kartoo.com/>

Kartoo, lancé en mai

2001 par une société française, se distingue par la présentation des résultats

sous forme de carte de connaissance publiée en technologie Flash ou en HTML.

·

METACRAWLER <http://www.metacrawler.com/>

C'est le premier outil

de ce type, développé à l'Université de Washington par Erik Selberg et Oren

Etzioni. Il organise les résultats en une liste triée par pertinence après

avoir éliminé les doublons.

·

PROFUSION <http://www.profusion.com/>

ProFusion utilise la

technologie d'IntelliSeek, spécialiste du web invisible. Il interroge plus de

mille sources dont de nombreux outils de recherche et plus de cinq cents

sources du web invisible.

Ø Les méta-moteurs clients

Dans ce cas, il faut

télécharger un logiciel et l'installer sur son poste de travail. En général,

les fonctionnalités sont plus importantes que dans le cas précédent. Il est en

particulier possible de planifier des recherches, ce qui s'avère intéressant

pour la veille et les rapproche de la catégorie des outils de recherche décrite

dans le paragraphe suivant. Cette famille de logiciels est en plein essor et

les produits nouveaux sont nombreux. En voici quelques-uns :

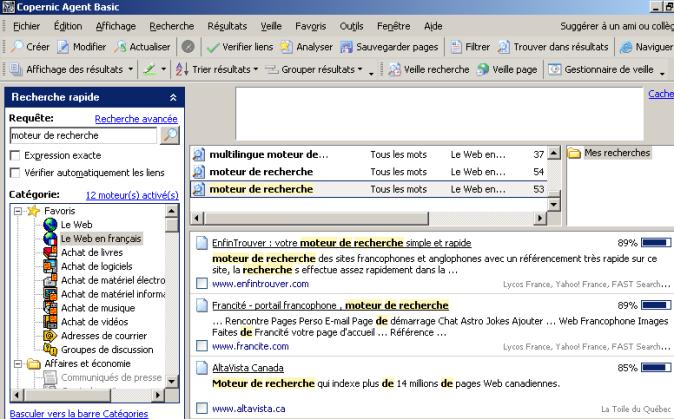

·

COPERNIC <http://www.copernic.com/>

(voir également document 9)

C’est le plus populaire de

ces outils. Une fonction de recherche par mots clés sur les résultats obtenus

est disponible. Pour la consultation hors ligne, il est possible de télécharger

tout ou partie des documents trouvés. Un historique détaillé des résultats,

classés dans des dossiers, peut être créé et mis à jour au fur et à mesure.

Autres outils :

·

GLOOTON <http://www.glooton.com/>

Créé en octobre 2000 par trois ingénieurs, il revendique sa spécificité par rapport à Copernic et Sherlock en se voulant beaucoup plus paramétrable, à l'aide de plugin disponibles sur le web. Il est gratuit

·

STRATEGIC FINDER <http://www.digimind.com/>

Strategic Finder produit par Digimind, société spécialisée sur le métier de la veille stratégique fondée en 1998. Strategic Finder permet également de traduire automatiquement votre requête dans le langage de n'importe quel moteur de recherche sur Internet. Pour cela l'ensemble des sources d'informations (plus de quatre mille) est rassemblé en catégories. Il propose toute une série de plugin pour rechercher par thème sur des outils de recherche spécifiques.

III-2. Les outils de recherche automatique

Les outils de recherche automatique d’information n’ont d’automatique que l’actualisation des recherches. En effet, pour une utilisation de tels outils, il est indispensable de les paramétrer et de les « rendre intelligent » avant même de commencer la première recherche.

En résumé ces outils permettent de récupérer, stocker et gérer automatiquement et de manière pertinente la grande quantité d'informations disponibles sur Internet et dans les intranets en fonction des requêtes de l’utilisateur. Ce sont des outils adapté à la veille. Voici en détail l’ensemble des fonctions remplies dans le meilleur des cas par les logiciels de recherche automatique d’information (voir aussi document 10) :

- Effectuer les recherches sur

plusieurs sources : à partir d’une requête ou de profils complexe

(par domaine ou sémantique) il s’agit de rechercher les informations dans

le Web, Gopher, usenet, mailing list, en utilisant les moteurs de

recherche mais aussi des sites non référencés sur ces derniers.

- Sauvegarder les documents

trouver : consulter les sites qui répondent à la requête pour

télécharger la page et la sauvegarder temporairement sur le poste de

l’utilisateur.

- Réactualiser les recherches

sur les sources : réaliser un suivi dynamique du contenu dans le

temps en comparant les documents initiaux avec les nouveaux documents.

- Filtrer en amont ces

documents : comparer les mots de la page à l’aide d’une méthode

linguistique ou sémantique afin d’éliminer les documents qui s’éloignent

du contexte.

- Sauvegarder les documents

pertinents : après le filtrage précédent, il s’agit de constituer une

base de données contenant seulement des documents répondant au mieux à la

requête.

- Générer un résumé

automatique : extraire le sens ou simplement prendre les premiers

mots de chaque document.

- Indexer l’ensemble des

documents filtrés : créer un index en texte intégral et générer un

dictionnaire des mots contenus dans l’ensemble des documents.

- Filtrer en aval les

documents : comparer les documents par différentes méthodes

(sémantique, linguistique, synonimique) afin de définir des ensembles

homogènes de documents en sous-thèmes.

- Présenter les résultats :

mettre en valeur les synthèses sous forme de carte (mapping), d’arbre, de

représentation graphique (2D, 3D), résumé de synthèse, afin de les

exploiter rapidement.

- Diffuser les synthèses

automatiquement aux personnes concernées. Fournir un service à haute

valeur ajoutée dans la diffusion de synthèses de documents.

L’organisation

de ces différentes fonctions représentée sur le document 10 page précédente

montre que le processus n’est pas unique puisque certaines fonctions, comme le

filtrage par exemple, peuvent être éliminées de la fonction globale de

recherche automatique.

Le logiciel

Copernic (version 6 payante de Copernic Agent Professional [20]) possède la plupart des fonctionnalités décrites mis à

part la fonction d’aide à la décision. De plus, pour ce logiciel la recherche

en « langage naturel » n’est disponible que pour la version en

anglais. Pour obtenir la génération automatique de résumé il faut se procurer

en plus le produit également payant « Copernic Summarizer » [21].

Le logiciel

Pericles plus complet de la société Datops [16] est aussi un outil adapté à la veille. Il est cependant

différent de Copernic qui ne fait qu’interroger les ressources des autres

moteurs de recherche pour constituer sa base de documents. En effet le logiciel

de la société Datops doit se constituer en aval ses propre ressources de

documents indexés. Nous reviendrons plus en détail sur ce logiciel un peu plus

loin dans ce rapport (paragraphe V-2).

IV-

LES TECHNIQUES D’INDEXATION

Les techniques d’indexation permettent de définir les critères utilisables en recherche et leurs conditions d’exploitation. Les moteurs d’indexation génèrent leurs propres index et y appliquent leurs algorithme de sélection et de tri. Les technologies employées sont propres pour chaque moteur, même si les principes peuvent être un peu généralisés. Ceux présentés ici sont schématiques et ont pour but d’expliquer le fonctionnement général.

IV-1. La technique d’indexation en

texte intégral

Tous les mots contenus de la page sont

insérés dans l’index, c’est la méthode la plus fréquemment employé puisqu’elle

tient compte de l’intégralité du texte. Il s’agit alors de construire un

fichier d’index qui comprenne, comme entrées, tous les mots du texte à indexer.

Ø Exclusion des

mots vides de sens

Il y a dans le langage écrit de nombreux mots qui

n’apportent que peu de sens au texte, bien qu’indispensable à la compréhension.

L’indexation du texte , pour éviter d’encombrer les fichiers, pour éviter

d’encombrer les fichiers, ne prend en général pas en compte ces mots, lors de

l’indexation. Ces mots vides sont, entre autres, les articles, les conjonctions

de coordination, mais également les adverbes, les formes conjuguées des

auxiliaires qui sont présent en grand nombre dans les textes. Ainsi dans la

phrase « Mais que fait la police ? », le seul terme exploitable

en recherche est le terme « police », les autres sont considérés

comme des mots vides.

Traditionnellement, on élimine d’emblée ces mots lors

de la construction des index de la base d’information, en les rassemblant dans

un dictionnaire de mots vides. En général, les éditeurs de logiciel proposent

de tels dictionnaires dans les principales langues. On peut ajouter ou

supprimer des mots vides dans ce dictionnaire, à l’initialisation de la base,

et éventuellement, ultérieurement.

Ø L’indexation

des mots

Il s’agit de construire un fichier d’index pour chaque

document qui comprenne, comme entrées, tous les mots du texte à indexer, à

l’exception des mots vides. Dans le document 11 est présenté de manière simplifié le principe

général de l’indexation à partir de deux pages Web. Dans chaque INDEX page un poids

est associé à chacun des mots du document qui représentera un index de

pertinence. Dans notre exemple ce poids est calculé en fonction de deux

critères : la fréquence d’apparition

et la localisation des mots dans le document.

Ø Calcul de la

fréquence d’apparition

A chacun des mots de l’index de la page est associé son nombre d’apparition dans la page Web : c’est la fréquence du mot notée F. Dans certain moteur un seuil de fréquence d’apparition du mot est fixé pour que le mot soit présent dans l’INDEX page.

Ø Calcul de la

localisation

En plus de la fréquence les fichiers d’index peuvent comprendre davantage d’informations : on les appelle aussi index positionnels. Pour chaque page, l’information gérée dans le fichier d’index comprend outre la clé, la position du mot dans le texte (colonne E=En-tête,U=url,T=Titre,I=Image,M=Méta). Cette position du mot peut être gérée en absolu, c'est-à-dire que lors de l’indexation, le moteur calcule la position du mot dans le texte par rapport à son début.

Elle peut aussi être gérée en fonction de la structure du texte (comme dans le document 11). Nous avons vu au paragraphe I-2 (document 1) les différents éléments de structure d’une page Web et son influence dans le référencement des moteurs : plus fort poids pour les mots présents dans les titres, prise en compte des informations contenues dans les balises META. Dans le document on a qu’un champ M pour balise META mais on peut imaginer découper ce champs en plusieurs champs pour conserver les informations des balises META comme les champs Auteur, Mots clés, …

Ø Création d’un

index inversé

Une fois l’indexation des mots de chacune des pages

effectué il y a création d’un index global inversé qui va référencer pour

chacun des mots les documents dans lesquels ils sont présents avec le poids

associé. Plus le poids d’un mot sera important dans la page, mieux cette page

sera classée dans l’index associé au mot. Par la suite lors d’une requête faite

par un internaute et contenant ce même mot, les pages apparaîtront dans cet

ordre. Pour une requête à plusieurs mots, par exemple contenant les mots MOTEUR

et DOSSIER, le retour se fera dans l’ordre des pages contenant MOTEUR et parmi

celles-ci dans l’ordre des pages contenant les mots MOTEUR et DOSSIER.

Les informations sur la localisation des mots dans le

document peuvent également être reporté dans l’index inversé. Conserver le

champ TITRE pourra permettre à travers

l’interface du moteur d’interroger la base sur une requête du type title : Moteur qui consiste à rapatrier tous les documents qui

contiennent le mots Moteur

dans leur titre. De même, conserver le

champ URL pourra permettre à travers l’interface du moteur d’interroger la base

sur une requête du type url :

Moteur qui consiste à rapatrier tous les

documents qui contiennent le mots Moteur dans leur url.

Ces fonctionnalités de recherche sont disponibles par exemple pour les moteurs

de recherche Altavista et Google.

Une indexation encore plus fine peut consister à

définir dans un document la position du mot par le numéro de section, le numéro

de paragraphe dans la section, le numéro de phrase dans le paragraphe, et le

numéro de mot dans la phrase. On parle alors aussi d’index positionnel. Ainsi

le moteur de recherche ne se contente plus de retrouver le document pertinent

mais pointe également sur la phrase ou la portion de phrase qui constitue une

réponse à la question. A noter que certains moteurs proposent une mise en sur

brillance des mots qui constituent une réponse à la question.

Conserver l’information sur la position des mots

permet aussi des recherches relativement plus évoluées que celles qui portent

sur la seule présence de mots dans un texte. Par exemple : Si on interroge

une base d’information sur les Moteur de Recherche, vous pourrez préciser que vous souhaiter trouver des

textes où Moteur et Recherche sont l’un à côté de

l’autre. Pour cela il est possible d’utiliser l’opérateur NEAR avec par exemple les moteur Alta Vista et Lycos (voir

paragraphe V-I pour plus d’information sur cet opérateur). Sinon vous

obtiendrez des tas de texte qui traiteront par exemple de la Recherche sur les Moteurs à combustion …

Le document 12 synthétise les

variantes qui peuvent exister au niveau de l’indexation en texte intégral

utilisé par les moteurs de recherche du Web. Des informations sur la structure,

le formats, la gestion et la mise à jour des index sont également disponible en

annexe

3.

IV-2. L’indexation par mots clés

Il s’agit de construire comme précédemment

un index inverse de mots en comparant cette fois tous les mots trouvés à une

liste. Cette liste sera utilisée, non pas comme dans le cas précédent, pour

éliminer les mots vides, mais au contraire pour garder uniquement les mots du

texte qui lui appartiennent.

Cela relève à présent de l’indexation contrôlée (par

utilisation d’un lexique de mot) à l’inverse de la technique d’indexation par

texte intégral qui est une technique d’indexation libre. Cette liste de mots

clés peu correspondre à un vocabulaire normalisé correspondant à tel ou tel

domaine comme par exemple une liste de mots clés pour le domaine juridique. Les

termes extraits peuvent aussi être pondérés en fonction de leur fréquence

d’apparition ou de leur localisation. VERITY Information Server [12] propose une indexation de ce type.

IV-3. L’indexation par Thésaurus

IV-3.1 Description et exemple

Un thésaurus est un vocabulaire d’un langage

d’indexation contrôlé organisé formellement de façon à expliciter des relations

a priori entre des concepts.

Cela peut être des relations génériques-spécifiques

correspondant à des notions d’hyperonymie/hyponymie (véhicule est un

terme générique ou hyperonyme de voiture ; deux chevaux est

un terme spécifique ou hyponyme de voiture).

Cela peut être aussi des relations d’association

correspondant à des notions de synonymie (oculiste est un synonyme d’ophtalmologiste).

Un thésaurus est conçu en principe selon des normes et des conventions

internationales [5].

Ainsi comme avec la liste de mots clés, le thésaurus

va limiter la liste des mots extraits des textes qui seront utilisés dans

l’indexation. Cependant la différence est que cette liste de mots dans le cas

du thésaurus est structurée et tous les mots de cette liste ne pointent pas

vers des documents. En effet un thésaurus se compose de termes descripteurs et

de non-descripteurs. Seul les termes descripteurs sont utilisés dans

l’indexation.

ØDescripteurs, ou termes préférentiels, ou termes

autorisés

Ce sont des mots simples ou composés du langage

courant (généralement des substantifs ou des groupes nominaux), qui servent à

désigner les concepts représentatifs du contenu des documents, et qui sont

utilisés aussi bien pour l’indexation que pour les requêtes.

ØTermes non-descripteurs, ou synonymes, ou termes

exclus

Ils désignent des concepts identiques ou voisins de

ceux représentés par les descripteurs. Ils ne peuvent être utilisés pour

l’indexation, et renvoient chacun à un ou plusieurs descripteurs autorisés. Ils

ont pour rôle essentiel de guider les indexeurs dans leurs recherches.

Dans le document 13 on peut

observer les relations qu’entretient le mot fibre avec d’autres termes

dans le Thésaurus de Statistique du Canada [4]. Cet outil bilingue d’indexage et de recherche documentaire

entièrement structuré a été mis au point afin de permettre aux utilisateurs

d’accéder aux ressources d’information de Statistique du Canada en effectuant

une recherche par sujet. Dans le document 11 les termes descripteurs sont en

bleu soulignés. Les termes non-descripteurs tels que fibres chimiques et

fibres naturelles sont en vert.

ØStructure du Thésaurus

Dans le Thésaurus, les relations sont hiérarchiques

(termes génériques ou spécifiques), associatives (termes associés) ou

normatives (employer ou employé pour). Les définitions suivantes vous aideront

à comprendre les différentes relations structurelles présentées dans le

document 13 par rapport au terme fibres.

Terme générique : le terme générique du mot fibres

est situé au dessus de lui dans la hiérarchie. C’est un terme descripteur qui a

un sens plus général que celui du mot fibres.

Terme spécifique : les termes spécifiques du mot fibres

sont situés en dessous de lui dans la hiérarchie. Ce sont des termes

descripteurs qui ont un sens plus restreint que celui du mot fibres.

Terme associé : les termes associés au mot fibres

sont liés à lui par association et non par hiérarchie dans le thésaurus. Ce

sont des termes descripteurs dont le sens est proche de celui du descripteur fibres.

Terme employé pour : ce sont des termes

non-descripteurs qui entretiennent un lien d’équivalence avec un terme

descripteur. Ils permettent d’obtenir un descripteur (ici le mot fibres)

à partir des termes non descripteur (ici Fibres chimiques, Fibres

naturelles). Ceci permet d’utiliser des synonymes, des quasi-synonymes et

des variantes lexicales.

ØConséquences au niveau de l’indexation

Un document contenant un terme descripteur comme Fibres

est également indexé par défaut par son équivalent générique (dans ce cas Produit

textile comme indiqué dans le document 13 page précédente). Il est possible

que ce même document soit aussi indexé par l’équivalent générique de Produit

textile (ex : Produits manufacturés). Le nombre de niveaux

varie en fonction des thésaurus.

ØConséquences au niveau de la recherche

Par défaut le système va inclure les termes

spécifiques liés à un terme descripteur dans une requête. Par exemple si l’on

fait une requête sur le mot Produit textile, le système va nous proposer

en premier les documents contenant le mot Produit textile puis ensuite

des documents contenant le mot Fibres qui est un terme spécifique du mot

Produit textile. Le choix d’inclure les termes spécifiques dans la

requête peut éventuellement être paramétré. Par contre si l’utilisateur fait une

requête sur le terme Fibres

chimiques, le système va alors proposer

de faire une recherche sur le mot Fibres car Fibres chimiques n’est pas un terme descripteur.

ØExemple du Thésaurus du MeSH

Le MeSH (Medical Subject

Headings) [5bis]

]est le

thesaurus de la base bibliographique Medline, thésaurus de référence dans le

domaine biomédical. Il s’agit d’un schéma de classification hiérarchique

comprenant 19000 sujets-clefs et codes principaux, utilisés pour l’indexation

des bases de données crées par la bibliothèque nationale de médecine (National

Library of Medecine) avec la participation de l’Inserm pour la version

française.

Chaque article de Medline se voit attribuer entre 6 et

15 sujets-clefs, avec un maximum de 3 pour les thèmes clés de l’article. Les

articles sont indexés suivant le terme le plus spécifique, afin de garantir un

très haut degré de précision lors d’une recherche par sujet. Les mots-matières,

c’est-à-dire les termes couvrant les aspects fréquemment mentionnés d’un sujet

(par exemple effet secondaires ou thérapie) sont ajoutés aux

termes MeSH pour identifier clairement le thème principal de l’article.

Les Medical Subject Headings sont révisés et

actualisés en permanence par des spécialistes, maîtrisant chacun un domaine

médical spécifique. Leur travail consiste à rassembler les termes nouveaux au

fur et à mesure de leur parution dans des ouvrages scientifiques ou de leur

utilisation dans de nouveaux domaines de la recherche, à définir ces termes

dans le cadre du vocabulaire normalisé existant, et à recommander leur

inclusion dans MeSH. Ils reçoivent également des suggestions de la part de

documentalistes ou d’autres professionnels.

Sur le site de PubMed [6] (l’équivalent de la base de donnée Medline au NCBI), une

option intitulé MeSH Browser permet de trouver plus facilement des mots clés

MeSH pertinents pour la recherche d’articles scientifiques sur un sujet.

Voici un exemple de recherche dans le thésaurus du

MeSH :

L’utilisateur souhaite traiter la question : Douleurs

associées aux traitements des cancers du sein ?

Il doit tout d’abord saisir l’expression : breast

cancerdans la fenêtre de recherche. Puis après avoir cliqué sur le bouton Go, le système indique que le terme breast cancer n’est pas un mot

clé MeSH mais il affiche la fiche descriptive du terme MeSH équivalent : Breast

Neoplasms.

La fiche descriptive du terme comprend : la

définition, l’environnement sémantique sous la forme d’une arborescence (document 14). L’arborescence correspond à

l’affichage hiérarchique du terme dans le thésaurus du MeSH. Un terme MeSH peut

appartenir à plusieurs arborescences.

Le bouton ADD permet d’ajouter

le terme substitutif Breast Neoplasms à la requête. Par défaut PubMed

inclut dans la requête les termes spécifiques liés au terme descripteur proposé

(ici Breast Neoplasms). La requête est donc étendue. Il est cependant

possible de limiter la recherche à Breast Neoplasms.

Il existe une autre option qui est accessible par

l’hyperlien [Detailed

display] en haut de la page. Elle permet

par une liste de cases à cocher associées à des qualificatifs, de limiter cette

fois la requête à un aspect particulier comme : analysis, blood, blood

supply. La requête booléenne peut ensuite être envoyée dans PubMed pour la

recherche de références bibliographiques.

IV-3.2 Avantage et inconvénient de la méthode d’indexation contrôlée par thésaurus par rapport à la méthode d’indexation libre du texte intégral

Les relations d’équivalence d’un thésaurus permettent

de résoudre le problème de la synonymie, qui est contourné grâce à la relation

« terme préférentiel (descripteur) / terme non-descripteur »

permettant de distinguer un descripteur parmi un ensemble de synonymes et de

les relier entre eux.

Les relations hiérarchiques permettent également

d’utiliser une technique dite d’autopostage (de automatic posting >

autoposting) lorsque l’indexation est automatique : lors de l’indexation

des textes, elle complète les notions spécifiques à l’aide de leurs termes

génériques ; lors de l’indexation d’une question posée avec des termes

génériques, elle permet de la compléter avec les termes spécifiques.

La résolution du problème de l’ambiguïté lexicale de

la langue est réalisée par le choix de descripteur non ambigu. Ces ambiguïtés

sont générés notamment par les phénomènes d’homographies et de polysémies. Une

homographie entre deux mots est une identité accidentelle de mots d’origines

différentes. Une polysémie est un mot ayant plusieurs sens. Prenons l’exemple de

la phrase « Les poules du couvent couvent. » qui comporte deux

formes d’homographes. Dans un thésaurus on pourra utiliser le terme descripteur

monastère comme descripteur du mot couvent.

Ce problème n’étant évidemment pas résolu par une

méthode d’indexation libre c’est ce qui explique que les moteurs de recherche

basés sur une technique d’indexation par texte intégral génèrent ce que l’on

appelle du bruit dans leur résultat. Il y a bruit si le système propose

comme réponse à une requête des documents non pertinents, c’est-à-dire ne

répondant pas à la question. En effet, une requête sur les transports aériens

utilisant la chaîne vol peut entraîner la sélection de textes parlant de

cambriolages – ou d’oiseaux – étant donné qu’aucune levée d’ambiguïté n’aura été

faite pour différencier les emplois du substantif.

Parmi ses inconvénients il faut souligner la

complexité de la mise en œuvre de l’indexation par thésaurus et sa mise à jour.

Ceci oblige pour obtenir un produit de qualité de faire réaliser cette indexation

de manière manuelle par des spécialistes du domaine. De plus le thesaurus étant

conçu avant tout pour l'indexation , il peut se prêter mal à la recherche à

partir du vocabulaire courant, ce qui en fait souvent un outil réservé à des

domaines spécialisés. La nécessité de maîtriser le langage avant la recherche,

l'absence de prise en compte de certaines relations associatives ou

d'équivalence peuvent entraîner du silence lors de l'interrogation. Le

silence est le fait qu’un système ne fournisse pas certains documents

pertinents pourtant contenus dans la base interrogée.

VI-4. Les méthodes linguistiques

IV-4.1 Introduction et comparaison par rapport aux méthodes

d’indexation précédentes

Nous avons vu que la technique d’indexation libre du

texte intégral privilégie l’exhaustivité par extraction et indexation de tous

les mots des textes (mis à part les mots vides). Des techniques statistiques

venaient ensuite effectuer des pondération sur ces mots pour établir un

classement par pertinence des documents au sein de l’index. Le rôle que c’est

fixé la linguistique automatique est d’améliorer cette pertinence en faisant

analyser des textes par des machines informatiques pour qu’elles en traitent le

contenu textuel et non pas uniquement les mots. Les traitements auront pour

tâche notamment de résoudre le problème de l’ambiguïté du langage aussi bien au

niveau de l’indexation que de la recherche.

On s’intéressera pour cela dans les premières phases à

une analyse morphologique des mots et à une analyse syntaxique de ces mots au

sein des phrases. Ces étapes d’analyses du texte en indexation permettront de

réduire le nombre et les types d’entrées d’index par rapport à un index en

texte intégral standard. Au niveau de la recherche elles permettront également

des interrogations plus riches comme par exemple une interrogation composée de

groupes nominaux et dans le cas le plus évolué des interrogations en langage

naturel (constitué de phrases complètes).

Il faudra cependant que les traitements linguistiques

soient effectués aussi bien au niveau de l’indexation qu’au niveau du texte de

la requête afin de faire correspondre les termes de la requête avec ceux de

l’index.

La dernière approche et nécessitant l’application des

analyses précédentes consiste à s’intéresser au sens des textes : c’est la

sémantique. On verra l’utilisation des ontologies à ce niveau qui consistent à

attribuer à un ensemble de mots un sens global qui s’apparente à des concepts.

Il est vrai que d’une certaine façon l’indexation par thésaurus prend en compte

la composante sémantique du langage mais d’une manière trop restrictive qui se

limite à un aspect « purement linguistique » de relations entre les

mots d’un texte. Les réseaux sémantiques (que l’on verra au paragraphe VI-2.1)

ont à peu près le même niveau d’usage que les thésaurus au niveau sémantique.

IV-4.2 Principes des techniques

linguistiques d’indexation

Les systèmes utilisant ce principe combinent

différentes analyses linguistiques pour le traitement du langage naturel. Ils

sont formés de plusieurs modules de traitement linguistique ayant chacun un

niveau d’analyse spécifique. Ces niveaux d’analyses peuvent aussi bien être

appliqués sur les textes à indexer que sur l’analyse du texte des requêtes.

Plusieurs moteurs de recherche et d’indexation

linguistiques sont présentés dans cette partie qui utilisent une ou plusieurs

techniques d’indexation. Ces outils tels que Intuition [13], Lexiquest[14],

Pertimm[15] n’ont pas besoin d’intervention

humaine pour réaliser leur indexation. Cependant il existe également des outils

qui proposent des méthodes semi-automatiques d’indexation. En annexe 5

on trouvera au sein d’une tentative de classification plusieurs outils qui

utilisent de la sémantique dans leur mode de recherche. Un moteur sémantique se

doit de réaliser au moins les trois premiers niveaux d’analyse parmi ceux qui

vont être présentés.

Les différents niveaux d’analyse linguistique sont les

suivant :

1) Le niveau

morphologique

On isole chaque terme par le biais d’un dictionnaire

qui permet le contrôle des chaînes de caractère et le repérage des mots. On

devra cependant prendre en compte le polymorphisme de mot appartenant à un même

concept, le traitement se traduit par la suppression des variantes

combinatoires (flexion, dérivation, conjugaison) pour obtenir une forme

canonique par réduction (appelé aussi lemmatisation). Les outils

nécessaires à ce procédé de réduction sont les dictionnaires de correspondances

entre formes fléchies ou dérivées et formes canoniques ainsi que des règles

d’établissement par correspondance. Par exemple produira, produisent, ont

produit etc., auront la même forme canonique produire (on dit aussi

que le terme produire est le lemme de ses formes fléchies produira,

produisent, ont produit).

Application en indexation (voir illustration document 15) : il existe des modes d’indexation libre par fichier

inverse de lemmes, obtenu par l’ensemble des opérations : découpage,

lemmatisation, élimination des mots vides, inversion. Il est également possible

de pondérer les index ainsi obtenus. On obtient en fait un index inversé de

mots comme dans la technique d’indexation en texte intégral (paragraphe IV-I).

Simplement par un traitement linguistique les mots qui pointent sur des

documents ont tous cette fois une forme lemmatisée

Dans ce cas au moment de l’interrogation, une

lemmatisation de la requête doit également être effectuée afin de faire

correspondre les termes de la requête avec ceux de l’index. Ce mode

d’indexation a un intérêt certain pour retrouver des concepts dans un texte,

même s’ils ont été exprimés dans la question sous une forme différente.

Par exemple si je réalise une recherche sur le terme

produire j’obtiendrait les documents contenant le terme produire mais

aussi les document contenant les formes fléchies de ce mot comme produisent,

produira, ont produit, etc. Dans le principe on réalise donc une expansion

de la requête. Le problème est que ce seul niveau d’analyse engendre des

ambiguïtés sémantiques.

Non seulement les formes fléchies peuvent correspondre

à plusieurs lemmes (le terme livres est soit le nom – féminin ou

masculin – au pluriel, soit le verbe conjugué à la deuxième personne du présent

de l’indicatif ou du subjonctif) mais un même lemme peut aussi être ambigu (présent

peut être associé au temps, à un cadeau, au fait d’être là).

Ainsi une analyse syntaxique complète des phrases doit être réalisée en

parallèle pour lever certains cas d’ambiguités.

Une indexation de ce type a été mise en œuvre dans les

logiciels suivants : AlethIP de LEXIQUEST[14](annexe 4),

Intuition de SINEQUA[13],

Pertimm de SYSTAL[15],

Spirit de TECHNOLOGIES-GID[11](annexe 4), Pericles de DATOPS [16], Exalead < http://www.exalead.com/>.

2)

L’analyse syntaxique :

L’analyse syntaxique part des phrases et consiste à

déterminer les regroupements structurels des mots au sein de ces phrases, ainsi

que les relations entre les mots, et les relations entre les structures de

mots. Elle cherche par exemple à obtenir des analyses de type sujet – verbe –

complément, ou plutôt groupe nominal sujet – groupe verbal – groupe

nominal complément. Dans la plupart des modèles syntaxiques, l’analyse

d’une phrase aboutit à une représentation hiérarchique ou arborescente, dans laquelle

les mots sont regroupés en unités intermédiaires ou syntagmes, qui

s’emboîtent les uns dans les autres. En sortie d’une analyse, on trouve ainsi

généralement un arbre syntaxique, avec des informations syntaxiques attachées

aux nœuds et aux extrémités des branche de cet arbre. L’exemple du document 16 montre

une phrase (simple) et son arbre syntaxique développé sur plusieurs niveaux.

Ainsi l’analyse syntaxique permet de résoudre quelques

cas d’ambiguïté en s’appuyant sur la structure grammaticale de la langue. Par

exemple dans la phrase « l’homme approcha une chaise de la table »,

le mot table ne peut être qu’un nom et pas la forme conjuguée du verbe tabler.

Application en indexation (voir illustration document 17). Certains systèmes utilisent un mode d’indexation libre par

fichier inverse de syntagmes ou mots composés. Sur ce type d’indexation, les

index peuvent être aussi pondérés par des critères statistiques. On trouve une

indexation de ce type dans Pertimm de SYSTAL[15], et Spirit de TECHNOLOGIES-GID[11]. Dans le logiciel Intuition de SINEQUA[13] et Pericles de DATOPS [16], on trouve un traitement

syntaxique plus poussé avec une indexation libre par syntagmes nominaux

étendus.

Par exemple les ellipses en particulier vont être

prises en compte ; par exemples, firmes publiques et privées

sera indexé par firmes publiques, firmes privées.

Un autre aspect est la normalisation de la catégorie

syntaxique des termes retenus : on n’indexera plus maintenant que par des

groupes nominaux. Cela conduit à nominaliser les verbes. Exemple : « La

visserie a été resserée » sera indexé par « resserrage de la

visserie »

L’indexation peut aussi être contrôlée à ce niveau en

utilisant des listes de termes autorisés pour déterminer parmi les groupes

nominaux reconnus ou générés ceux qui sont correct. Le risque est alors à

nouveau d’obtenir du silence en éliminant des termes présent dans le texte à

indexer mais non répertoriés dans la liste de référence.

3)

L’analyse

sémantique :

C’est l’analyse du sens du texte.

On distingue deux niveau d’analyse sémantique :

la sémantique lexicale et la sémantique du discours.

-

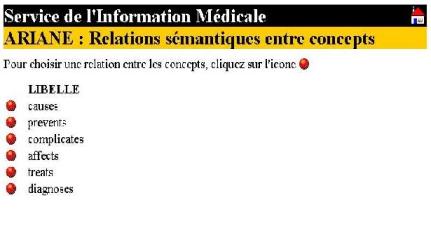

La sémantique

lexicale :

Elle s’appuie sur l’analyse du texte pour déterminer

les concepts qu’il contient ; elle privilégie donc l’analyse des mots et

des groupes de mots. Elle s’appuie sur les réseaux sémantiques par exemple. Un

réseau sémantique est un graphe formé de nœuds, qui représente des concepts,

reliés par des arcs orientés et étiquetés, qui représentent les relations

sémantiques entre ces concepts. Il est aussi appelé graphe de concepts. Nous

verrons des exemples de réseaux sémantiques et

des exemples d’utilisation dans le paragraphe VI-2.

-

La sémantique du

discours ou pragmatique :

L’analyse du discours est beaucoup plus ambitieuse et

tend à analyser le sens du texte complet, ce qui est très complexe. En effet,

dans un même texte, on peut trouver des phrases apparemment contradictoires, du

point de vue purement lexical.

Exemple de l’indexation contrôlée à l’aide

d’ontologies : Le principe est

d’utiliser des listes de catégories ou champs sémantiques appelés aussi ontologie.

La définition d’une ontologie est la suivante :

une ontologie est un catalogue sémantique, dont les descriptions sont à la fois

concises, non ambiguës, et qui se doit d’être exploitable par un logiciel

(description formelle) comme par un opérateur humain (description littéraire).

Les ontologies sont des structures hiérarchiques

censées représenter les choses du monde. Il y a deux approches différentes:

- Trouver une taxinomie des

concepts les plus généraux. Cette ontologie de niveau supérieur vise à

englober la totalité des concepts, sans pourtant entrer dans les détails

des concepts spécifiques.(Guarino, 1997) (document 18)

- Trouver une hiérarchie de

concepts d'un domaine limité, par exemple de la législation, de la

production de voitures, de la maladie de cancer... Cette ontologie de

domaine peut contenir des représentations de concepts spécifiques très

détaillées.

Il s’agit donc en fait d’unités de sens assez généraux

qui servent à regrouper des termes voisins plus spécialisés qui ont la même

signification ou dont le sens est proche. Par exemple sur le document 18 (page

précédente) ont constate que les termes homme, animal et plante

peuvent être rattaché à l’unité de sens être vivant.

Avant de rattacher des mots à une unité de sens un

certain nombre de regroupements préalables entre les mots doivent être

effectués :

-

Regroupements

morphologiques permettant de constituer des familles de mots regroupés autour

d’un représentant canonique, dont la seule fréquence d’apparition sera prise en

compte (produire, producteur, productrice, productif, productive sont

rattachés à production). Le niveau sémantique comprend donc les niveaux

d’analyse morphologique et syntaxique que l’on a vu précédemment.

-

Regroupements

synonymiques et analogiques permettant de ramener à une seule unité des formes

différentes mais liées entre elles par leur relation de sens (scanner=numériseur=digitaliseur ;

carcéral, prison, enfermement, etc.) ;

-

Regroupements

hyperonymiques permettant de regrouper sous un terme générique un ensemble de

termes spécifiques (machine à laver le linge, machine à laver la

vaisselle, fer à repasser, etc. sont regroupés sous le terme

générique électroménager).

Pour réaliser les deux derniers regroupement on pourra

s’aider éventuellement de thésaurus ou de réseaux sémantiques.

On obtiendra au final une liste de libellés de sens

qui constituera l’ontologie.

Pour exemple, le logiciel Intuition de la société

SINEQUA[13] utilise 770 champs sémantiques de

référence, dans lesquels les principaux mots et expression de la langue

française ont été classés.

L’utilisation d’une telle ressource en indexation est

la suivante (voir illustration document

19): les mots et termes qui sont extraits des documents sont

d’abord filtrés à l’aide d’une liste terminologique. Il est ensuite possible, à

partir d’une analyse statistique, de déterminer quels sont les concepts de

l’ontologie les plus représentatifs du texte, et d’utiliser le libellé de ces

concepts comme index. Il s’agit là d’indexation contrôlée qui atteint

véritablement le niveau sémantique.

Ce type d’indexation était potentiellement réalisable

par AlethIP de LEXIQUEST [14].

La principale difficulté de ce mode d’indexation tient

à l’attribution correcte des concepts ou champs sémantiques au texte, en

fonction de son contenu. Là encore, si certains concepts spécifiques d’un

domaine sont absents de la liste de référence, ils n’apparaîtront pas dans

l’index, et cela sera source de silence.

Ce type d’indexation présente le gros avantage de la

généralité et de l’indépendance de la représentation des textes par rapport au

vocabulaire utilisé : les index sont indépendants du vocabulaire, et c’est

véritablement les concepts, c’est à dire le niveau purement sémantique qui prime.

Cependant, ce qui est gagné en généralité est forcément perdu en précision.

IV-4.3 Deux niveaux d’utilisation des

techniques linguistiques

Nous passé en revue les différents traitements

linguistiques qui peuvent s’appliquer sur des documents textuels en vu de leur

indexation. La finalité de ces traitements étant d’améliorer la pertinence des

résultats en autorisant dans le cas le plus évolué une recherche en langage

naturel. La situation idéale est obtenu lorsque textes et questions sont

exprimés dans un même, référentiel, dont le caractère univoque autorise une mise

en correspondance exacte des index et des requêtes. Pour cela dans le cas

d’un mode de requête en langage naturel, les traitements linguistiques peuvent

intervenir non seulement au niveau de l’indexation mais aussi de l’analyse de

la question.

Ainsi deux types de solutions sont disponibles sur le

marché :

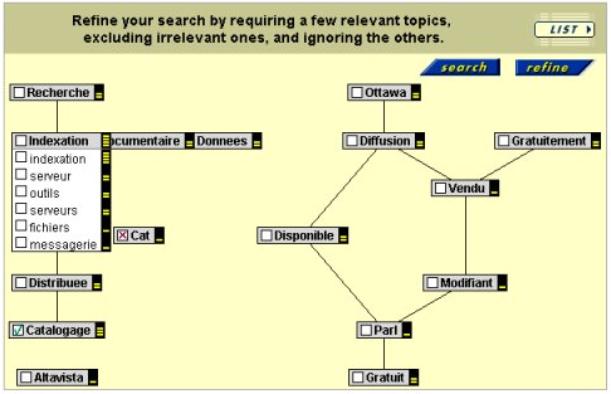

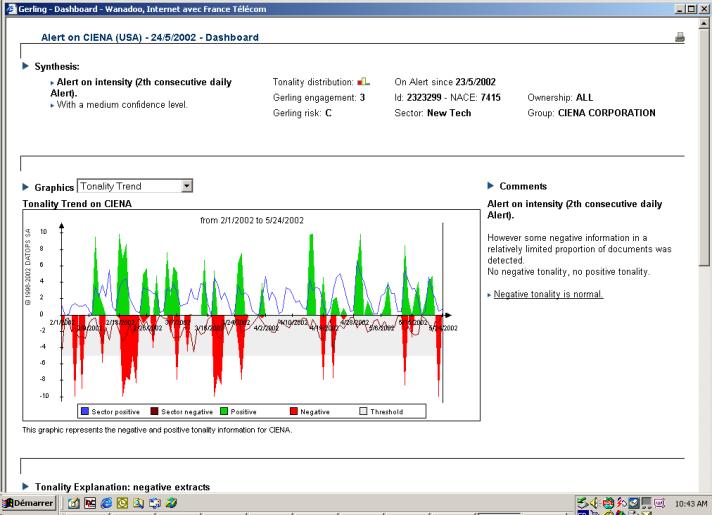

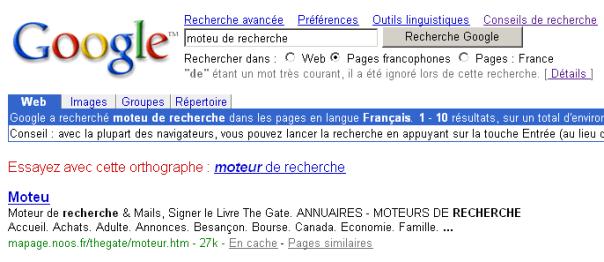

-la première solution privilégie l’analyse